Hola, ¿Qué tal? La verdad, estoy bastante emocionado con esta serie de artículos sobre IA. Esta sería nuestra tercera entrega. En las anteriores hablamos del origen y evolución de la inteligencia artificial, y en la segunda estuvimos hablando en uno de sus campos más interesantes: el Procesamiento del Lenguaje Natural.

Pero ahora toca uno de los huesos duros, una joya para quienes disfrutamos optimizando sistemas, depurando líneas de código y exprimiendo CPUs: hoy vamos a ver qué es el aprendizaje automático, cómo se estructura desde las matemáticas hasta el despliegue, y por qué se ha convertido en la piedra angular de la IA moderna.

¿Qué es el aprendizaje automático? Definición real, no de PowerPoint

El aprendizaje automático o machine learning, es un campo dentro de la IA que se encarga de crear algoritmos que aprenden a partir de datos. Nada de scripts con lógica estática tipo if-else; aquí estamos hablando de sistemas que mejoran conforme acumulan experiencia, como si tu compilador decidiera por sí solo cuándo aplicar una optimización en tiempo de ejecución según tus patrones de programación. Pero con datos.

No basta con entenderlo como «una parte de la inteligencia artificial«. El aprendizaje automático es el motor predictivo detrás de Google, Netflix, Tesla, GitHub Copilot y los sistemas de detección de intrusos más eficientes que usamos en ciberseguridad.

La idea es simple, pero poderosa: entrenas un modelo con un dataset, y ese modelo «aprende» a hacer cosas que antes solo podía hacer un humano. ¿Cómo funciona el ML? Muy resumido: se alimenta de datos etiquetados o sin etiquetar, calcula errores entre lo que predice y lo que debería predecir, y ajusta sus parámetros internos (pesos, funciones, coeficientes, etc.) para minimizar ese error.

Por cierto, si te preguntas ¿Es difícil el aprendizaje automático para principiantes?, la respuesta es: depende de cómo te lo expliquen. Si te dan definiciones sacadas de manuales de estadística, te vas a querer arrancar los ojos. Pero si lo ves como una extensión de tu lógica de programación (con estructuras de datos, funciones de coste, optimización y control de errores), todo empieza a tener sentido.

Machine Learning explicado fácil (sin perder el respeto técnico)

Vale, pongamos un ejemplo geek: imagina que estás entrenando a tu asistente de escritorio para que adivine si el correo que recibes es spam. No le das reglas tipo «si contiene la palabra Viagra, marca como spam«. En lugar de eso, le pasas 10.000 emails con la etiqueta «spam» o «no spam«, y de ahí el sistema aprende qué patrones estadísticos hacen sospechoso un mensaje.

Tú no programas la lógica; le das los datos, y él infiere la lógica. Eso es machine learning en estado puro.

Y para responder a otra de las preguntas clave: ¿Qué se necesita para aprender aprendizaje automático? Te diría que tres cosas:

- Mentalidad de programador estructurado (vas a ver muchos pipelines)

- Curiosidad por los datos (vas a pelearte con ellos más que con el propio modelo)

- Cierta base matemática (pero no hace falta haber hecho un doctorado en álgebra lineal, tranquilo).

Fundamentos del aprendizaje automático: lo que hay debajo del capó

Aquí es donde el friki interno se pone a aplaudir. Porque para entender de verdad cómo funciona el aprendizaje automático, necesitas sumergirte en la trastienda matemática.

Te resumo lo más importante:

- Álgebra lineal: vectores, matrices, operaciones matriciales. Si has hecho cálculos de trayectorias en videojuegos o manipulación de gráficos 3D, ya sabes de qué va.

- Estadística y probabilidad: distribuciones, varianza, correlaciones, inferencias. Necesitas entender cómo se comportan los datos, no solo almacenarlos.

- Optimización: descenso del gradiente, funciones de pérdida, mínimo global vs. local. Aquí es donde el modelo afina su rendimiento.

- Cálculo diferencial: usado para entender cómo cambia la función de pérdida con respecto a los parámetros del modelo.

Un modelo, no es más que una función matemática ajustada para minimizar una pérdida. Punto. Y esa pérdida es el resultado de comparar lo que el modelo predice con lo que debería haber predicho. Si alguna vez programaste una función de error personalizada en tu motor de físicas, ya sabes de qué va esto.

Tipos de aprendizaje automático: el multiverso del ML

Aquí es donde el asunto se vuelve interesante. En el universo del aprendizaje automático, no todo es blanco o negro, pero sí hay tres grandes galaxias que definen las formas en que los modelos aprenden. Es como hablar de lenguajes de programación: tienes paradigmas distintos, cada uno con su lógica interna, ventajas, limitaciones y usos ideales. Pues en ML pasa lo mismo.

1. Aprendizaje supervisado: la vieja confiable

Esto es como enseñarle a tu sistema a programar mostrándole miles de líneas de código y su resultado. Tienes datos de entrada y sabes exactamente qué salida se espera para cada uno. Aquí el modelo se entrena con un dataset etiquetado, lo que significa que cada ejemplo está perfectamente identificado.

Esencialmente, el sistema aprende a mapear entradas a salidas. Si le das la suficiente cantidad de ejemplos, el modelo generaliza lo aprendido y es capaz de predecir la salida para nuevos datos no vistos.

Algunos ejemplos:

- Clasificación de correos como spam o no spam

- Detección de tumores en radiografías

- Predicción del precio de una vivienda en base a sus características.

Los algoritmos más comunes aquí son:

- Regresión lineal y logística

- Máquinas de vectores de soporte (SVM)

- Árboles de decisión y Random Forest

- Redes neuronales multicapa.

2. Aprendizaje no supervisado: el caos ordenado

Si el supervisado es como un curso con profesor y exámenes corregidos, el no supervisado es el autodidacta; no hay etiquetas. El sistema recibe los datos “en crudo” y debe buscar estructuras internas por sí mismo. Agrupa, reduce dimensiones, encuentra patrones ocultos, sin que nadie le diga lo que es “correcto”.

Piensa en un algoritmo que analiza logs de actividad en un sistema de red. No hay etiquetas, pero si ve que ciertos patrones de tráfico son estadísticamente distintos a los habituales, te puede alertar de un posible ataque.

Ejemplos de aplicación:

- Segmentación de clientes en marketing

- Detección de anomalías en sistemas de seguridad

- Reducción de dimensionalidad en grandes datasets.

Algoritmos típicos:

- Clustering con K-means

- PCA (Análisis de Componentes Principales)

- Modelos de mezcla gaussiana.

3. Aprendizaje por refuerzo: cuando el modelo juega para ganar

Este es el más friki de todos, y también el más adictivo. Es el sistema de aprendizaje que más se parece al comportamiento humano. No hay etiquetas, no hay estructuras, solo un entorno, un agente, y una recompensa.

Es el modelo que aprende por ensayo y error. Prueba algo, recibe feedback (positivo o negativo), y ajusta su comportamiento para maximizar la recompensa futura.

Aquí no se predice, se decide. Se trata de optimizar estrategias.

Casos de uso conocidos:

- Robots autónomos que aprenden a caminar o a evitar obstáculos

- Sistemas de trading algorítmico que aprenden a comprar y vender activos

- Modelos que aprenden a jugar videojuegos (¿recuerdas a AlphaGo? Exacto, eso).

Técnicas más utilizadas:

- Q-Learning

- Deep Q-Networks

- Métodos de gradiente de política.

El aprendizaje por refuerzo es pura estrategia computacional. ¿Cómo funciona el ML aquí? El modelo toma decisiones en función del estado del entorno, evalúa la recompensa y modifica su política de acción para obtener mejores resultados en futuras interacciones. Es como programar una IA para que se enseñe a sí misma a jugar ajedrez… y termine ganándote siempre.

¿Cuál es mejor?

Depende del problema; la elección del tipo de aprendizaje no es un dogma; es una cuestión de contexto, datos disponibles y objetivos. En algunos proyectos incluso se combinan enfoques. Pero si estás empezando y te preguntas ¿qué se necesita para aprender aprendizaje automático?, te recomiendo iniciarte con problemas de clasificación y regresión usando datasets bien etiquetados. Nada como entrenar a tu primer modelo para distinguir gatos de perros para entender los fundamentos del ML.

Y no, no es difícil el aprendizaje automático para principiantes, si tienes el enfoque correcto. Lo complicado no es entender qué hace un modelo, sino saber cuándo usar cada técnica y cómo preparar bien los datos para que el algoritmo no trabaje con basura.

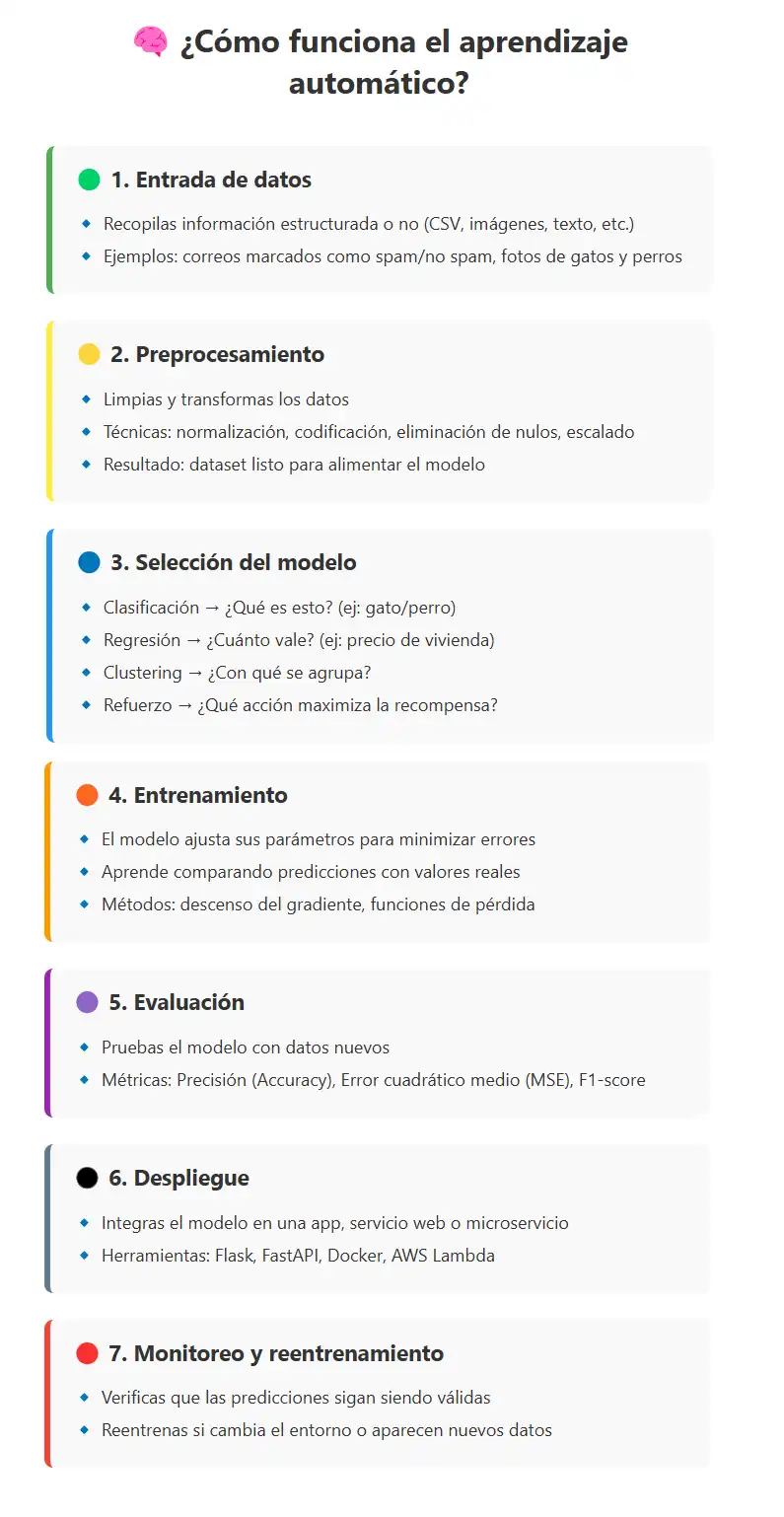

El flujo de trabajo en Machine Learning: del dato a la decisión

La gente suele imaginarse que hacer un sistema de aprendizaje automático consiste en tirar un CSV dentro de un modelo y darle a “entrenar”. Como si fuera una especie licuadora con Python para generar una batido. Nada más lejos de la realidad.

Un pipeline de ML profesional es una cadena perfectamente estructurada, como una arquitectura de microservicios bien diseñada. Todo depende de cada fase. Si fallas en una, el modelo final será como una aplicación sin validaciones: peligrosa y propensa a romperse en producción.

Paso 1: recopilación de datos

Este paso es puro instinto de hacker. A veces tienes una base de datos relacional, otras veces haces scraping, o tiras de APIs públicas, logs de sistema, sensores IoT, ficheros en crudo o incluso imágenes. Aquí entra la creatividad y la capacidad de entender el contexto.

Un dataset puede estar en CSV, JSON, XML, en una base de datos de producción o incluso escondido en PDFs. Lo importante es que sin datos, no hay aprendizaje.

Paso 2: limpieza y preprocesamiento

Aquí es donde la mayoría de modelos mueren antes de nacer. Limpiar los datos es como depurar un código lleno de null, valores erróneos y columnas que no significan nada. Es la parte menos sexy del proceso, pero la más crítica.

- Eliminación de duplicados

- Relleno o eliminación de valores faltantes

- Normalización de variables

- Conversión de categorías a numéricos (label encoding, one-hot).

- Creación de nuevas variables a partir de otras (feature engineering).

Es justo aquí donde te das cuenta de cómo funciona el aprendizaje automático en la vida real: no aprende nada si los datos están podridos.

Paso 3: entrenamiento del modelo

Ahora sí viene el momento Matrix. En esta fase, defines qué tipo de modelo vas a usar (clasificación, regresión, clustering, etc.) y con qué algoritmo lo vas a entrenar.

Durante el entrenamiento, el modelo ajusta sus parámetros internos (los famosos pesos) para minimizar la función de pérdida, que mide qué tan mal lo está haciendo. Si programaste alguna vez un sistema que se autoajusta, este concepto te resultará familiar.

Aquí aplicamos técnicas como:

- Validación cruzada

- Regularización para evitar el sobreajuste

- Ajuste de hiperparámetros.

Paso 4: validación y evaluación

Nunca, repito, nunca evalúes un modelo con los mismos datos con los que lo entrenaste. Es como evaluar un estudiante dándole las respuestas del examen.

Aquí separas los datos en entrenamiento, validación y test. Usas métricas como:

- Accuracy, precisión, recall y F1-score (para clasificación)

- MSE, RMSE o MAE (para regresión).

Y entonces llega ese momento glorioso en que ves que tu modelo no solo “funciona”, sino que generaliza. Y si no, lo mandas de vuelta a entrenamiento. Como un script mal optimizado.

Paso 5: despliegue

Un modelo que no se despliega, es como un sistema que nunca sale de staging(entorno de pruebas). Para este momento, hay que empezar con el MLOps (Machine Learning Operations): integras tu modelo con una API REST, lo montas sobre un microservicio, lo metes en un contenedor Docker o lo sirves desde una función Lambda.

Pero ojo: el trabajo no termina aquí. Tienes que monitorizar el modelo, ver si sus predicciones siguen siendo buenas, y reentrenar cuando cambie el entorno. Esto es como mantener un firewall actualizado, no es cuestión de hacerlo una vez y olvidarse.

Herramientas esenciales para profesionales del ML

Podría hablarte de frameworks de juguete, pero si quieres ponerte serio con esto del machine learning, vas a acabar tocando al menos una de estas tres:

1. TensorFlow

Creado por Google. Potente, escalable y muy usado en producción. Se usa para todo tipo de modelos, desde simples regresiones hasta redes neuronales profundas.

Ideal si vas a trabajar con grandes volúmenes de datos y necesitas aprovechar GPUs.

Ventajas:

- Compatible con TensorFlow Lite (para móviles)

- TensorFlow.js (para web)

- Alto rendimiento con arquitectura distribuida.

2. PyTorch

Mi favorito personal; más flexible, más intuitivo, con un enfoque más dinámico. Lo usan mucho en investigación y prototipado rápido.

PyTorch te permite jugar con modelos casi como si estuvieras en un REPL (bucle leer-evaluar-imprimir). Perfecto si te gusta entender lo que pasa “debajo del capó”.

Usado por OpenAI, Meta, Tesla…

3. Scikit-learn

La navaja suiza del aprendizaje automático clásico. Para tareas más tradicionales como regresión lineal, clustering, SVM, árboles de decisión. Súper útil para proyectos donde no necesitas Deep Learning, pero sí buenos resultados con bajo coste computacional.

Lo mejor de Scikit-learn es su integración con NumPy, Pandas y Matplotlib. Es lo más cercano a tener un entorno de análisis profesional sin salir de Python.

¿Qué se necesita para aprender aprendizaje automático? Pues saber manejar al menos dos de estas tres herramientas. No necesitas ser gurú en todas, pero sí entender sus diferencias, fortalezas y casos de uso ideales.

Ejemplo 1: Clasificación de imágenes (gatos vs perros)

Este es el “Hola mundo” del Deep Learning. Una red neuronal convolucional (CNN) aprende a distinguir si una imagen contiene un gato o un perro.

Pasos reales:

- Dataset: usas el clásico «Cats vs Dogs» de Kaggle

- Pre-procesas imágenes (rescalado, normalización, data augmentation)

- Creas una CNN con TensorFlow o PyTorch

- Entrenas usando entropía cruzada como función de pérdida

- Evalúas precisión sobre el conjunto de test

- Despliegas el modelo con una API que reciba imágenes y devuelva predicciones.

Este ejemplo es perfecto para comprender cómo funciona el ML en tareas visuales, donde los datos son más complejos que simples tablas.

Ejemplo 2: Regresión básica (predicción de precio de vivienda)

Tienes un CSV con precios de casas, metros cuadrados, número de habitaciones, barrio, año de construcción, etc. ¿Objetivo? Predecir el precio de una casa nueva en base a esas variables.

Pasos:

- Limpieza de datos (eliminar nulos, codificar barrios)

- Escalado de características

- Selección de variables más influyentes

- Entrenamiento con regresión lineal o Random Forest

- Evaluación con MAE y RMSE

- Despliegue del modelo para usarlo como sistema de valoración automático.

Este tipo de modelos se usa en fintechs, portales inmobiliarios, bancos y aseguradoras. Y sí, sigue siendo el favorito para enseñar los fundamentos de la regresión.

Aplicaciones actuales del aprendizaje automático

Cuando explico en clase o en consultorías qué puede hacer el ML, siempre empiezo con una frase simple: “si puedes convertir un problema en datos, puedes automatizar su solución con ML”. Y esa premisa está transformando industrias enteras.

Aquí van algunos sectores donde el aprendizaje automático no es una promesa, sino una realidad en producción:

- Medicina

- Diagnóstico por imagen asistido por IA (radiografías, resonancias, análisis de retina)

- Predicción de enfermedades a partir de historiales clínicos

- Modelos de atención preventiva personalizados.

- Ciberseguridad

- Detección de anomalías en tráfico de red

- Clasificación de malware en tiempo real

- Sistemas adaptativos de defensa (IDS/IPS inteligentes).

- Finanzas

- Detección de fraudes en transacciones en milisegundos

- Scoring de crédito más justo y dinámico

- Modelos de predicción bursátil (sí, con sus limitaciones, pero útiles).

- E-commerce y marketing

- Recomendaciones personalizadas (Amazon, Netflix, Spotify).

- Segmentación dinámica de clientes.

- Optimización de precios en tiempo real.

- Transporte y logística

- Predicción de demanda y optimización de rutas.

- Mantenimiento predictivo de flotas.

- Sistemas de navegación inteligente en tiempo real.

Como vemos, el aprendizaje ya forma parte de todos los sectores económicos de la sociedad. De hecho es ya es infraestructura invisible.

Los grandes desafíos del aprendizaje automático

No todo es entrenar modelos y jugar con TensorFlow. Hay problemas complejos, de esos que hacen que a los veteranos les tiemble el café encima del teclado.

Veamos esos aspectos a considerar:

1. Sesgos y discriminación

Este es un punto crítico. Si entrenas un modelo con datos sesgados, el modelo amplificará esos sesgos. Y esto no es solo un problema técnico: es ético, social y legal.

Por ejemplo, un modelo que recomienda créditos y ha sido entrenado con datos históricos donde se discriminaba por zonas o perfiles sociales… seguirá haciéndolo, pero con una máscara matemática.

Por eso, parte del trabajo profesional consiste en:

- Auditar datasets

- Evaluar fairness

- Incluir métricas de equidad.

- Testear los modelos en subgrupos poblacionales.

2. Calidad de datos

Los modelos no son mágicos, si le das basura, no hay algoritmo que lo arregle. He visto pipelines enteros caer por columnas con más del 60% de datos faltantes, por variables mal codificadas o por registros duplicados mal detectados.

Aquí entra la ingeniería de datos, la validación automatizada, el versionado de datasets y un trabajo fino de preprocesamiento que, aunque parezca aburrido, es la base para que todo lo demás funcione.

3. Interpretabilidad

¿Sabes por qué las redes neuronales son criticadas en sectores como medicina o legal? Porque a veces no puedes explicar por qué predicen lo que predicen. Son como cajas negras.

Y hay escenarios donde no basta con una predicción acertada; necesitas justificarla.

Por eso, en proyectos sensibles:

- Se prefieren modelos interpretables (árboles, regresiones)

- Se usan técnicas de explicabilidad como SHAP, LIME o análisis de sensibilidad.

Porque no puedes ir a un cardiólogo y decirle: “el modelo dice que tiene un infarto, pero no sé por qué”.

El poder de entender los datos

Si me preguntas hoy por hoy cuál es la habilidad más poderosa que puede tener un informático en 2025, te digo sin dudarlo: entender cómo funciona el aprendizaje automático.

Porque esto, definitivamente no es tecnología más… Es un cambio de paradigma, es pasar de programar reglas a entrenar modelos que se adaptan. Y eso transforma cómo escribimos código, cómo protegemos sistemas, cómo analizamos información y cómo tomamos decisiones.

Así que si estás empezando, o si vienes de la programación tradicional y te preguntas por dónde entrar: arranca con un modelo supervisado, entrena tu clasificador de gatos y perros, y empieza a preguntarte qué más podrías automatizar.

Porque en este mundo de datos, el que sabe entrenar modelos no solo escribe software. Escribe futuro.

¿Te gustaría empezar un modelo propio? Busca datasets públicos en Kaggle, clona un repositorio con notebooks, instala Scikit-learn y empieza a jugar. Y si necesitas guía, aquí seguiremos escribiendo cada fin de semana para que entiendas, practiques y transformes el mundo digital. Desde cero. Con cabeza de programador.